撰文 | 王培(美国天普大学计算机与信息科学系)

近年来计算机的“智力”所达到的范围越来越广了,人脑的各种功能纷纷被AI再现,尽管不少仍是在初级阶段。即使如此,还是有一些领域被普遍认为是机器无论如何也无法染指的,比如情感。一个常见的断言是“人工智能可以有理智,但不可能有真正的情感”。这种观点有悠久的历史根源,但不必去查哲学史,我们也知道“理智”和“情感”一般被看作是对立的,而且屡屡被告诫在做决定时不应该“感情用事”,因为那是非理性的。在传统的理性模型中是没有情感的位置的,而AI系统作为这些模型的具体实现,自然没有情感可言,随便找一本AI教科书就可以证实这一点。科幻小说和电影也反复强化了这种观念,以至于“像机器人”往往成了对那些思维有条理,处事冷静,情感不外露的“理工男”的常见评语。但近年来,这种传统观念开始受到挑战。

“情”在“理”之中

在对人类认知活动的研究中,情感的作用被越来越多的研究者认为是不可或缺的了。这些作用体现在“自我控制”和“人际交流”这两个方面。

有些情感体现着对系统自身状况的评价,比如(正面的)愉悦、得意和(负面的)悲痛、悔恨。另一些情感则体现着对外界对象的评价,比如(正面的)喜爱、亲切和(负面的)痛恨、厌恶。不同的情感会引发不同的应对策略,比如说同为负面情感,愤怒会令人欲战,而恐惧则会令人欲逃。和通过深思熟虑才采用的行动相比,情绪化反应有直接、快速的特点,尽管常常失之粗疏草率。

由于很多人类情感伴有面部表情和躯体反应,它们也因此在人际交流过程中发挥着语言所难以企及的作用。这其中包括基于对他人情感的识别来决定自己的应对(察言观色),以及通过情感表达来影响他人的行为(动之以情)。

上述对情感的功能描述并不涉及情感的生理基础。这也就是说在计算机系统中原则上也可能有类似的需求以及实现类似功能的机制。这也就是目前AI中相关工作的出发点。在现有的研究中,主要关注点分别对应前面的“控制”和“交流”两个方面。

近年来兴起的“情感计算”就是试图在人机交互过程中包括情感成分,以便更好地服务于用户。在和人交流的过程中,这种系统会识别用户的情感状态,并采取相应的行为,包括模拟人类的情感表达。各种聊天程序和玩具机器人都在这方面绞尽脑汁,希望取悦使用者,甚至满足使用者的情感需求。

通用人工智能(AGI)中的情感研究则基本是在另一个方向上。这里的主要目标不是让计算机看起来像是懂得或拥有人类情感,而是让它们真的有自己的情感,即主要以这一机制满足系统自身的需求,而不是满足用户的需求。在这个过程中,系统的“情感”是否和人类的完全一样并不重要,而重要的是其产生、发展、效用等等是否和人类情感的相应方面类似。近年来已经有若干“机器情感”的模型被提出和初步实现了。由于篇幅的限制,我这里不能对各种方案进行全面讨论,而下面只介绍我们自己团队在这方面的探索。

纳思(那厮)的情感

我在前面的多篇文章(比如《你这是什么逻辑?》,点击左下角“阅读原文”可获取)中介绍过我设计的AGI系统“纳思”,而现在的专栏名“AI那厮”也是源于此处。这次轮到谈其中和情感有关的侧面了。和以前一样,下面的描述是高度简化的,有兴趣或疑问的读者可以去看我们的论文甚至源程序。

纳思和其它AI系统的一个根本性的差别就是其“知识和资源相对不足”假设。简单地说,就是系统对于它要实现的目标往往有“不知道”的和“没想到”的。在这个限制下,系统无法保证总能找到绝对正确或最佳的解,而只能提供它目前想到的最好的解,尽管它始终在努力积累经验以提升自己的能力和效率。

这个限制一个直接的结果就是纳思不能对所有目标一视同仁。由于系统中的目标往往互相冲突(所谓“鱼和熊掌不可兼得”),系统无法保证做到十全十美。对一个具体事件而言,系统对它的“愿望”(希望其发生或不发生)和系统对相应“现状”判断(实际发生了或没发生)的比较就决定了系统在这方面的“满意”程度。如果希望发生的确实发生了,或不希望发生的确实没发生,那系统就满意;如果不希望发生的却发生了,或希望发生的却没发生,那系统就不满意。由于愿望和现实判断在纳思里都是有不同程度的,满意也是个程度问题。这就是纳思中情感的起源,即作为对某方面现状的主观评价。

各方面的满意程度的总和构成系统对现状的总体满意程度。当然,在这个“汇总”过程中,各个事件的“权重”各有不同,一个大的“不如意”需要很多小的“如意”才可能抵消。由于时间资源的限制,纳思在做这个评价时不可能考虑到系统中的所有事件,而仅仅是其中少数那些当前或近期在系统的注意范围之内的。这个总体满意程度就决定了系统当前的基本情绪状态,也就是“高兴”或“不高兴”的程度。一般说来,系统极少“万事如意”或“处处碰壁”,而是处于某个中间状态。即使如此,总体情绪也有“正、负”之分,取决于“如意”和“不如意”的相对比例。

在此基础之上,系统中的概念及其对应的事物也都会被沾染上各种情感色彩(也可以称为“好恶”值),主要反映了它们和系统总体满意程度的相关性。如果系统和一个对象打交道时常常感到高兴,尽管该对象和系统状态可能其实并无因果关系,但系统仍会给它一个正面的评价(比如“爱屋及乌”),反之则是负面的评价(比如“迁怒”)。就好比如果我每次碰到某人都会伴随着某种不愉快的体验,我对此人就会产生某种负面情感(比如警惕),这也不能说是毫无来由的。当然很多事物可能从来也没有被带上任何此类感情色彩,也有事物处于“爱恨交织”的状况。

随着系统内外环境的变化,上述情感因素均会变化,但缓急不同。对个别事件的满意程度随愿望和现实的接近或背离而随时改变,可是系统的整体情绪状态变化相对而言就要慢些。对事物的情感是历史上多次评价的总结,变化就更缓慢了。无论如何,这些因素体现了系统本身对情境和事物的主观评价,因而构成了系统对它们在“客观描述”之外的另一种认识。这里的重点不是事物本身的属性,而是它们和系统愿望之间的关系。比如说系统在认识了客户甲乙丙丁之后,除了记住了他们的姓名、职业等等之外,还记着他们对自己是否“友好”。

在系统没有足够的知识或时间对各个事物进行细致的针对性处理的情况下,仅依靠它们的“感情色彩”决定应对往往不失为一种在统计意义下有效的便捷策略。在目前的纳思中,情感因素的影响主要体现在下列方面:

1. 在其它因素相同的条件下,带有强烈情感色彩(不论正面还是负面)的概念和任务会得到更多的注意,也就是更多的时间和空间资源。这就是说,如果用户给纳思下达了三个同等重要的任务,但它不可能有时间全都完成,那它就会依照自己对它们的不同“喜好”程度来分配时间。

2. 在目标之间发生冲突时,情感评价会成为选择的重要根据。这可以被作为“两人掉河里先救谁”之类的心灵拷问的合理性基础。

3. 在决策过程中,带有强烈情感的任务更容易触发系统的外部行动,而不必付出深思熟虑所要求的时间代价。“情急之下”的反应尽管往往在事后看来不是最优的,但却很可能是救了命的。

4. 在系统“心情好”的时候,它会给新任务和相对不重要的任务更多的考虑;相反,在“心情差”的时候,它往往聚焦于当下的难题。根据前面的描述,心情差说明有重要目标尚未达成,这时自然不该分心再去干别的。

当然,上述设计仅仅触及了情感机制的简单形式,而后面任务还有很多。在纳思的研发计划中,主要包括情感的进一步分化(通过满足感和其它概念的结合,比如区分其不同的特征)和各种情感的不同后果,情感在外部交流中的使用和辨识,“同情”的形成和限度,自我情绪调节和控制等等。当纳思被实现在机器人系统中时,情感会被用来影响更多方面,比如系统的能源消耗速率(一个机器人跑多快将取决于它多着急)等等。

机器情感的界定和后果

尽管很初等,目前的工作起码已经展示了将情感引入通用人工智能的理由和可能性。根据我的智能定义(见《人工智能:何为“智”?》,点击左下角“阅读原文”可获取),情感并不是智能的一个必要成分,但却是高级智能系统的自然需求,因为情感机制能让系统在约束条件下更有效地使用知识和资源。根据上面的解释,“情感”和“理智”尽管可以密切协作,其间的差别依然存在,因为后者一般基于对明晰表达的当前信念和目标的直接处理,而前者的来源和表达常常难于分析和辨识。但这绝不说明情感是空穴来风,是“非理性”。“情感”或许更应该被看作“理智的积淀”。比如说爱憎的来源尽管常常难以说清,却绝不是没来由的。

这不是说传统的理性模型都错了。它们针对的问题是目标单一而且知识资源充分,而在那种条件下情感往往的确只能添乱。但现实并不总是那么井井有条。多目标的竞争要求系统能做出轻重缓急、亲疏远近之间的分别,而时间压力要求快速反应。情感的确有很多负面后果,但在很多情况下没有情感反而会更糟。

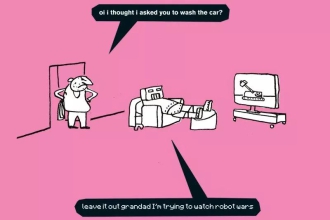

对本文观点的一个预料之中的反对意见是说纳思不能算有“情感”,因为其中找不到多巴胺、肾上腺素、荷尔蒙等等的对应物,它也不会“喜上眉梢”或“怒发冲冠”。和在很多其它关于AI的讨论中一样,这里的关键是要不要在“人类情感”和“动物情感”之上引入一个更一般的(功能性的)“情感”概念。只要承认这种抽象的必要性,是否管它叫“情感”就主要是个用词习惯的问题了。如果“情感”一定要被定义为动物才能有,我们可以管纳思的相应机制叫“机情”,但这实际上并不影响这个机制和人类情感的相同点和不同点。比如说如果你设计的机器狗有这种机制,那你如果在测试其平衡能力时经常踹它(像那个广为流传的录像里那样),就不要奇怪它为什么总躲着你了。如果你的机器人不干活而跑去看电视,那也没什么可奇怪的。

这当然就会导出对“机器情感”的另一个反对意见,即担忧其社会后果:如果机器人恨人类怎么办?在我看来恰恰相反:让人工智能有情感很可能是保证这一技术的安全性的必然要求。对一个有自主性和适应性的系统来说,由设计者完全事先决定其在所有情况下的反应是不可能的。如果希望它在未来千变万化的情况下按我们的期望来行为,让系统可以辨别喜恶和区分轻重缓急就是必然的了。一个从心里爱人类的AGI远比一个仅仅牢记各种道德戒律的要安全得多。当然这里还有很长的路要走(怎么让它爱人类?电影《A.I.》中那种“思想钢印”靠谱吗?),旅途中又是机会和挑战同在,可这不正是科学探索的本色吗?

对机器情感研究的另一个结果是使我们对情感在人类思维中的作用得到进一步的认识。和注重于情感生理机制的研究不同,AGI在这方面的贡献会是揭示情感发生的功能性前提和后果,而在这里计算机提供了一个精确的实验平台。甚至连精神疾病的研究都可能从这里得到启示。以纳思为例,如果情感成分在系统决策过程中起的作用太大或太小,系统都会表现出某种“病态”,而我们或许会在其中发现和人类精神疾病类似的地方。

参考文献

1. Pei Wang, Max Talanov, and Patrick Hammer, “The Emotional Mechanisms in NARS”,Proceedings of the Ninth Conference on Artificial General Intelligence, pages 150-159, New York City, July 2016

2. Jean-Marc Fellous and Michael A. Arbib (editors), Who Needs Emotions? The Brain Meets the Robot, Oxford University Press, 2005

本文为严肃科普媒体《返朴》(微信号:fanpu2019)首发,《返朴》由国际一流科学家和科普专家担任总编及编委。任何媒体转载时须保留《返朴》名称及微信号和作者信息。未经许可,严禁对包括标题在内的任何改动。转载、授权、合作请联系fanpu2019@outlook.com。

免责声明:本文由用户投稿,(图文、音视频)均由用户自行上传分享,文章内容不代表本站立场,本站不对其内容的真实性、完整性、准确性给予任何担保、暗示和承诺,仅供读者参考,文章版权归原作者所有。若您的权利被侵害,请联系本站在线客服进行删除。